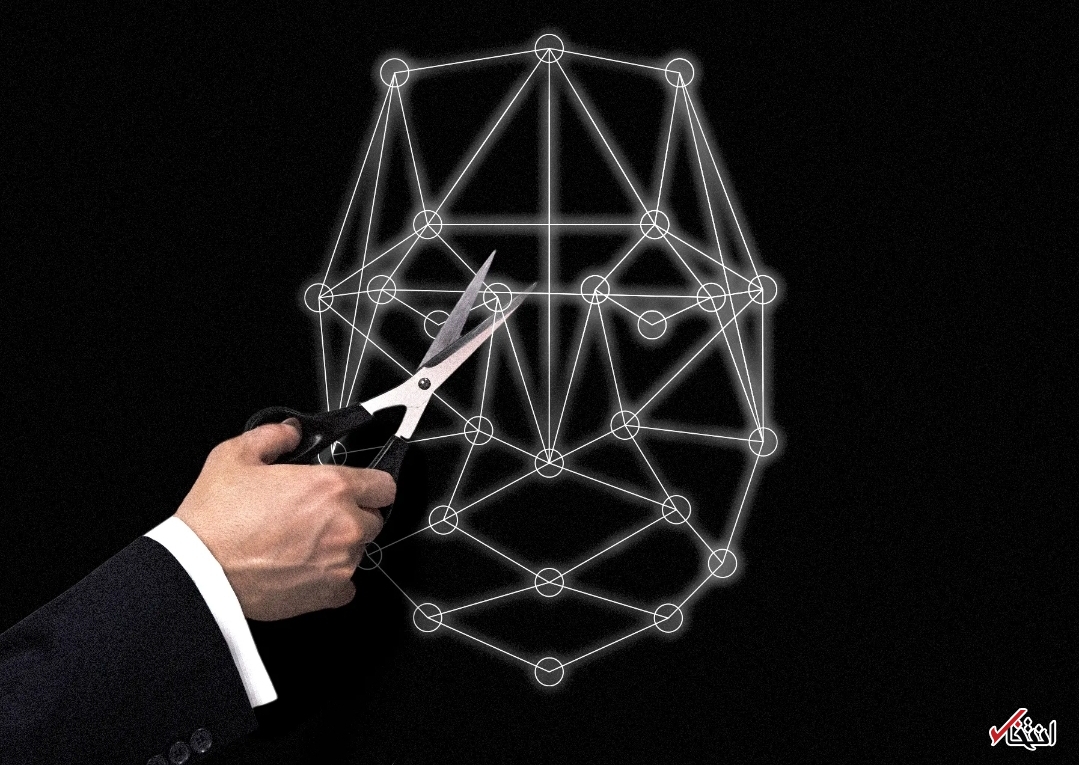

یک تیم حرفهای و جدید در پنتاگون (تیم قرمز)، سعی در پیش بینی و خنثی کردن حملات مبتنی بر هوش مصنوعی با شیوهای جدید دارد. پنتاگون هوش مصنوعی را راهی برای برون رفت از شرایط خطر، پیروزیهای بیشتر و تسلط بر دشمنان آینده میداند. اما ماهیت شکننده هوش مصنوعی به این معنی است که بدون مراقبتهای لازم، این فناوری میتواند راهی جدید برای حمله به دشمنان بدهد.

به گزارش سرویس خواندنیهای انتخاب، مرکز اطلاعات مصنوعی مشترک، ایجاد شده توسط پنتاگون برای کمک به ارتش ایالات متحده در استفاده از هوش مصنوعی، اخیراً واحدی را برای جمع آوری، طراحی و توزیع مدلهای یادگیری ماشینی منبع باز و صنعتی در گروههای سراسر وزارت دفاع تشکیل داده است. بخشی از این تلاشها به چالشی اساسی در استفاده از هوش مصنوعی برای اهداف نظامی اشاره دارد.

سیستم هوش مصنوعی موسوم به "تیم قرمز"، معروف به گروه آزمون و ارزیابی، مدلهای از پیش آموزش دیده شده را برای شناخت نقاط ضعف بررسی میکند. تیم امنیت سایبری دیگری کدهای هوش مصنوعی و دادهها را برای آسیب پذیریهای پنهان بررسی میکند.

سیستم یادگیری ماشینی، نوعی تکنیک با پشتوانه هوش مصنوعی مدرن، شیوهای کاملاً متفاوت و اغلب قدرتمندتر، برای نوشتن کد رایانه را نشان میدهد. یادگیری ماشینی به جای نوشتن قوانین برای پیروی از ماشین، قوانین خود را با یادگیری از دادهها ایجاد میکند. اما مشکل این است که، این فرایند یادگیری، همراه با مصنوعات یا خطاهای موجود در دادههای آموزشی، میتواند باعث شود که مدلهای هوش مصنوعی به شیوههای عجیب یا غیرقابل پیش بینی رفتار کنند.

گرگوری آلن، مدیر استراتژی و سیاست در مرکز اشتراک و توسعه هوش مصنوعی (JAIC)، میگوید: "برای برخی از برنامهها، نرم افزار یادگیری ماشینی یک میلیارد بار بهتر از نرم افزار سنتی است. اما نمیتوان فراموش کرد که سیستم یادگیری ماشینی به روشهای مختلف از نرم افزارهای سنتی تبعیت میکند. "

برای مثال، یک الگوریتم یادگیری ماشینی آموزش دیده برای شناسایی وسایل نقلیه خاص در تصاویر ماهوارهای، ممکن است یاد بگیرد که وسیله نقلیه را با رنگ خاصی از مناظر اطراف مرتبط کند و یک دشمن میتواند با تغییر مناظر اطراف وسایل نقلیه خود، هوش مصنوعی را فریب دهد؛ بنابراین با دسترسی به دادههای آموزشی سنتیتر، ممکن است دشمن بتواند تصاویری مانند یک نماد خاص را که الگوریتم را گیج میکند، ایجاد کند.

آلن میگوید پنتاگون در مورد قابلیت اطمینان و امنیت نرم افزاری که استفاده میکند از قوانین دقیق پیروی میکند. او میگوید که این رویکرد میتواند به هوش مصنوعی و یادگیری ماشین گسترش یابد و خاطرنشان میکند که JAIC در تلاش است تا استانداردهای دفاعی را در مورد نرم افزار به روز کند تا مسائل مربوط به یادگیری ماشینی را شامل شود.

تام گلدشتاین، دانشیار، علوم کامپیوتر، دانشگاه مریلند میگوید: "ما نمیدانیم که چگونه سیستمهایی کاملاً مقاوم در برابر حملات خصمانه بسازیم. " هوش مصنوعی در حال تغییر و تحول در نحوه فعالیت برخی مشاغل است، زیرا میتواند روشی کارآمد و قدرتمند برای خودکارسازی وظایف و فرایندها منجر شود. این روشی جایگزین برای نوشتن یک الگوریتم است که مشخص میکند مشتری کدام محصول را خریداری میکند، به عنوان مثال، یک شرکت میتواند الگوریتم هوش مصنوعی را در هزاران یا میلیونها فروش پیشین بررسی کند و مدل خود را برای پیش بینی اینکه چه چیزی خریداری میکند، طراحی کند.

ارتش آمریکا و سایر گروههای نظامی مزایای مشابهی را تجربه کرده اند و در حال استفاده از هوش مصنوعی برای بهبود تدارکات، جمع آوری اطلاعات، برنامه ریزی ماموریت و فناوری تسلیحاتی هستند. توانایی روزافزون فناوری چین باعث شده تا در پنتاگون در مورد تصویب هوش مصنوعی فوریتی ایجاد شود. آلن میگوید وزارت دفاع "در حال حرکت" به روشی مسئولانه است که ایمنی و قابلیت اطمینان را در اولویت قرار دهد.

محققان در حال توسعه روشهای خلاقانهتر برای هک، براندازی یا شکستن سیستمهای هوش مصنوعی هستند. در اکتبر سال ۲۰۲۰، محققان در اسرائیل نشان دادند که چگونه تصاویر دقیق با دقت میتوانند الگوریتمهای هوش مصنوعی را که به تسلا اجازه میدهد راه را تفسیر کند، به اشتباه بیندازند. این نوع "حمله خصمانه" شامل تغییر در ورودی الگوریتم یادگیری ماشینی برای یافتن تغییرات کوچک است که باعث خطاهای بزرگ میشود.

داون سونگ، استاد دانشگاه UC برکلی که آزمایشهای مشابهی را روی سنسورهای تسلا و سایر سیستمهای هوش مصنوعی انجام داده است، میگوید حملات به الگوریتمهای یادگیری ماشینی در زمینههایی مانند تشخیص تقلب در حال حاضر مسئلهای مهم است. برخی از شرکتها ابزاری را برای آزمایش سیستمهای هوش مصنوعی مورد استفاده در امور مالی ارائه میدهند. سونگ میگوید: "به طور طبیعی مهاجمانی وجود دارند که میخواهند از سیستم فرار کنند. من فکر میکنم در آینده شمار بیشتری از این نوع مسائل را خواهیم دید. "

یک مثال ساده از حمله یادگیری ماشینی شامل Tay، در مایکروسافت است که به یک ربات گفتگو محور مرتبط است. این ربات که در سال ۲۰۱۶ شروع به کار کرد، از الگوریتمی استفاده کرد که یاد گرفت چگونه با بررسی مکالمات قبلی به سوالات جدید پاسخ دهد. اما در سوی دیگر میدان، هکرها به سرعت دریافتند که میتوانند از این فناوری سوءاستفاده کنند تا Tay را وادار به پخش پیامهای نفرت انگیز کنند.

تام گلدشتاین، دانشیار دانشگاه مریلند که شکننده بودن الگوریتمهای یادگیری ماشینی را مطالعه میکند، میگوید که روشهای زیادی برای حمله به سیستمهای هوش مصنوعی وجود دارد، از جمله اصلاح دادههایی که یک الگوریتم تغذیه میکند تا رفتار خاصی داشته باشد. وی میگوید مدلهای یادگیری ماشینی با نرم افزارهای معمولی متفاوت است، زیرا دستیابی به یک مدل میتواند به دشمن اجازه دهد حملهای مانند ورودی گمراه کننده را طراحی کند که در برابر آن نمیتوان از خود دفاع کرد.

گلدشتاین میگوید: "ما واقعاً نمیدانیم چگونه همه آسیب پذیریهای را برطرف کنیم. ما نمیدانیم که چگونه سیستمهایی کاملاً مقاوم در برابر حملات خصمانه بسازیم. "در زمینه نظامی، جایی که یک دشمن از نظر فنی و پیشرفته از نظر منابع کاملاً مشخص است، محافظت در برابر انواع خطوط جدید حمله ممکن است از اهمیت ویژهای برخوردار باشد.

گزارش اخیر مرکز امنیت و فناوریهای نوظهور دانشگاه جورج تاون هشدار داده است که "مسمومیت با داده" در هوش مصنوعی ممکن است تهدیدی جدی برای امنیت ملی باشد. این روش شامل نفوذ به فرایند مورد استفاده برای آموزش یک مدل هوش مصنوعی است و شاید با حضور یک عامل داوطلب برای برچسب گذاری تصاویر به الگوریتم یا کاشت تصاویر روی وب که یک مدل هوش مصنوعی را تحت اثیر میگذارند.

اندرو لون، نویسنده این گزارش، JAIC را به دلیل ایجاد تیم اختصاص داده شده برای بررسی سیستمهای هوش مصنوعی پیشگیری از آسیب پذیریها تحسین میکند. وی هشدار میدهد که ایمن سازی خط یادگیری ماشینی برای مدلهای هوش مصنوعی که از بخش خصوصی میآیند دشوارتر خواهد بود، زیرا ممکن است نحوه توسعه آنها مشخص نباشد. همچنین ممکن است شناسایی دادههایی که برای مسموم کردن یک مدل هوش مصنوعی طراحی شده اند چالش برانگیز باشد، زیرا ممکن است این تغییرات برای چشم انسان واضح یا قابل مشاهده نباشد.

البته لونت میگوید، پنتاگون احتمالاً تواناییهای تهاجمی خاص خود را برای معکوس کردن مهندسی سیستمهای هوش مصنوعی، تخریب کردن و براندازی دشمنان دارد. درواقع به نظر میرسد، تمرکز بر این است که نتوان هوش مصنوعی نظامی آمریکا را مورد حمله قرار داد. وی میگوید: "ما میتوانیم گزینههای تهاجمی داشته باشیم. اما بگذارید فقط مطمئن شویم که علیه ما نمیتوان این کار را انجام داد. " آلن، مسئول JAIC، از اظهارنظر در مورد اینکه آیا ایالات متحده تواناییهای تهاجمی را توسعه میدهد، خودداری کرد.

بسیاری از کشورها، استراتژیهای ملی هوش مصنوعی را برای اطمینان از استفاده هرچه بیشتر اقتصاد از یک فناوری جدید قدرتمند، توسعه داده اند. هم اکنون، شرکتهای بزرگ فناوری در ایالات متحده و چین به ویژه در تلاش برای استفاده از جدیدترین تکنیکهای هوش مصنوعی در تجارت و صادرات هستند.

آلن میگوید داشتن یک امتیاز فنی در هوش مصنوعی یک مزیت استراتژیک برای دولتهای ملی خواهد بود. الگوریتمهایی که زنجیره تأمین نظامی را برای ادامه کار یا تصمیمات مهم مأموریت حفظ میکنند، باید محافظت شوند. او میگوید: "هنگامی که شما در مقیاسهایی بزرگ کار میکنید که دلهره آور محسوب میشوند و حکم شرایط مرگ و زندگی را دارد و در سیستمهای کاملاً پیچیده فناوری کار میکنید، به نوعی برتری فنی عمیق نیاز دارید تا اطمینان حاصل کنید که سیستمهای شما همانطور که در نظر گرفته شده عمل میکنند. "